Das模型3D运动追踪,指定对象视频动作同步

在当今的人工智能视频生成领域,Diffusion as Shader(DaS)实现了一项重大突破,即支持在视频生成过程中引入 3D 追踪能力,并将其作为控制信号输入。这一创新举措赋予了视频生成过程 3D 感知能力,为视频创作带来了更为广阔的可能性。

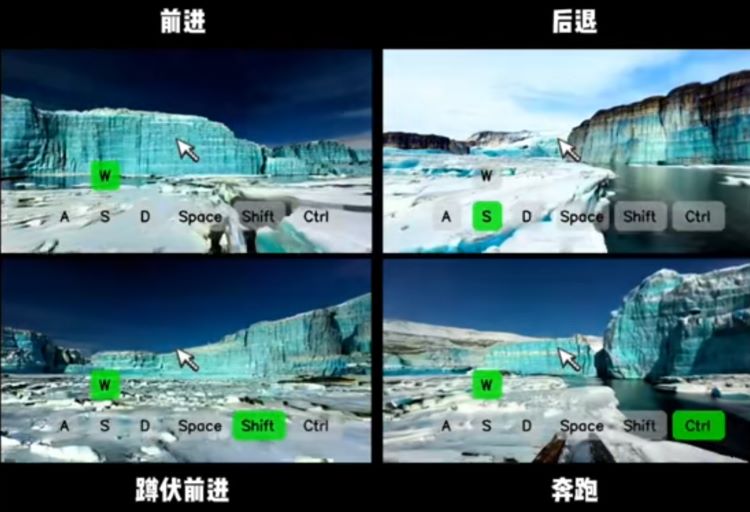

以往的视频生成技术在处理复杂的空间场景和动态变化时,往往存在一定的局限性。而借助 3D 追踪能力,Diffusion as Shader(DaS) 能够精准捕捉物体在三维空间中的位置、姿态和运动轨迹等信息,并将这些信息转化为控制信号,融入到视频生成的算法之中。

在具体的生成过程中,这种 3D 感知能力发挥着关键作用。它可以对视频中的各个元素进行精确的定位和调整,使得场景的构建更加符合真实的物理空间逻辑。无论是宏大的建筑场景,还是细腻的人物动作,都能够以更加自然、逼真的方式呈现出来。

更为重要的是,这一技术实现了广泛的视频生成应用,能够满足不同领域、不同风格的视频创作需求。从影视特效制作到虚拟现实场景构建,从游戏动画设计到教育培训视频制作,Diffusion as Shader(DaS)都展现出了强大的适应性和创造力。

同时,该技术在控制有效生成时间方面表现卓越,能够实现非常一致的真实过渡效果。在视频内容的衔接和转换过程中,不会出现突兀或不协调的情况,保证了视频整体的流畅性和连贯性。这使得生成的视频无论是在视觉效果还是叙事节奏上,都能够达到更高的水准,为观众带来更加沉浸式的观看体验。Diffusion as Shader(DaS)的这一创新成果,无疑为视频生成领域注入了新的活力,推动着整个行业向更加智能化、真实化的方向发展。